前回の「Angel Bridge USベンチャー記事#10」は、後払い決済(BNPL)を提供する世界的にも有名なデカコーン企業klarnaについて紹介しました。

Angel Bridge USベンチャー研究#10

今回は、法人向けの大規模言語モデルを開発するユニコーン企業Cohereについて紹介します。

生成AI市場の全体像

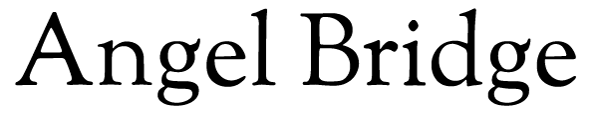

2022年11月にChatGPTが公開されてから、生成AIを用いたプロダクトが次々と登場し生成AI市場は非常に盛り上がっています。ボストン コンサルティング グループは生成AIの市場規模が27年に世界で1210億ドル(約17兆円)に達する可能性があると予測しています。足元ではChatGPT deep researchが話題であり、毎日のように生成AIの精度は向上しています。

図1:生成AIの市場規模予測(※ボストン コンサルティング グループ)

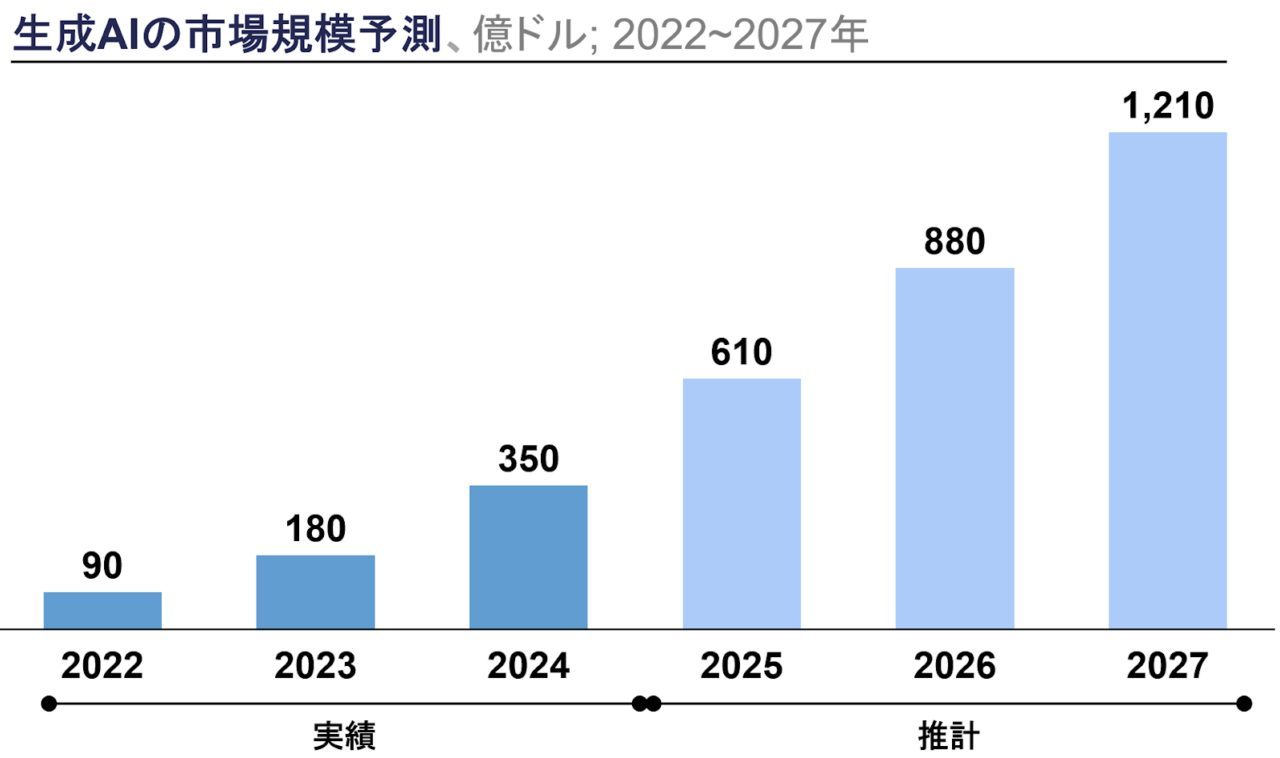

生成AI市場は大きく以下の3レイヤーに分類することができます。

基盤モデルを基にしたのと外部APIを活用するアプリケーションの対比では、AIモデルの優位性だけでいえば、基盤モデルを基にしたアプリケーションに軍配が上がるでしょう。理由の一つとして挙げられるのはAIモデルの差別化です。外部API依存のアプリケーションを提供する企業は参入障壁が低く圧倒的な優位性を築けている企業が少ないのに対し、独自の基盤モデルを基にアプリケーションを提供する企業は優位性を築けています。

既存SaaS vs AI-nativeアプリケーション

既存SaaSとAIを主軸に構築されたAI-nativeアプリケーションの置かれている状況を対比します。AI-nativeアプリケーションは、既存SaaS企業による生成AIの導入に対抗しなければいけません。生成AIは過去のテック革命(ネット革命、クラウド革命、スマホ革命)と比較して、Distribution Channelに変化がないという特徴があります。具体的に説明するとスマホ革命では、スマホファーストなアプリを提供したUberなどがタクシーなどの既存企業をディスラプトしました。一方で、AI革命ではチャネルの変化はありません。AI-native 基盤モデルはAPI経由でのアクセスが可能です。よって、既存SaaS企業がAPI経由で生成AIを実装することが可能となっており、AI-native アプリケーションは既にチャネルを抑えている既存のSaaS企業からシェアを獲得しなければいけない難しさがあります。

アプリケーションレイヤーでの勝ち筋

一方で外部APIを活用したアプリケーションにも十分に勝機があります。AIモデル自体は外部のものをベースとするものの、特に業界などに特化したデータセットの構築や、エンタープライズ企業をはじめとした特定顧客へのカスタマイズ、カスタマーサクセスなどアプリケーション提供のオペレーションなどで優位性を構築するAIアプリケーションスタートアップは数多く存在します。日本の市場は産業ごとに障壁があるケースも多く、日本におけるAI企業の多くがこの領域で勃興すると考えています。

②基盤モデル

概要:AIアプリケーションを動かす、基盤となるモデルのこと。大規模言語モデル(LLM)や画像生成モデルなどが存在します。また、権限を持つユーザーのみアクセス可能なクローズドソース(ex GPT4o)と誰でもアクセス可能なオープンソース(ex Stable Diffusion)の形態が存在します。

クローズドソースvsオープンソース

クローズドソースとオープンソースの勢力を対比します。基盤モデルはこれまで、クローズドソースが優位とされ、外部からの資金調達も含め膨大な資本投下のもと、技術開発が集中的に行われてきました(ex OpenAI)。しかし、近年ではオープンソースの基盤モデルが急速に注目を集めています。例えば、Metaが公開したオープンソースのLlaMaモデルは、世界中のエンジニアによるチューニングにより、わずか数週間でChatGPTと同等レベルのアプリケーションが開発されました。このような「オープンソースコミュニティ」の存在により、従来のクローズドソースモデルが持つ独占的な優位性が揺らぎ始めています。

基盤モデルレイヤーの勝ち筋

汎用的な基盤モデルのプレイヤーは基本的には資本力がものをいう世界であり、後発企業がこの領域で勝つのは難しいといえるでしょう。ただ一方で、汎用的な基盤モデルの課題として企業の具体的なニーズに個別に答えるのが難しいという課題が存在し、業界やユースケースに合わせてカスタマイズしたバーティカル基盤モデルは一定の参入余地はあると考えられます。

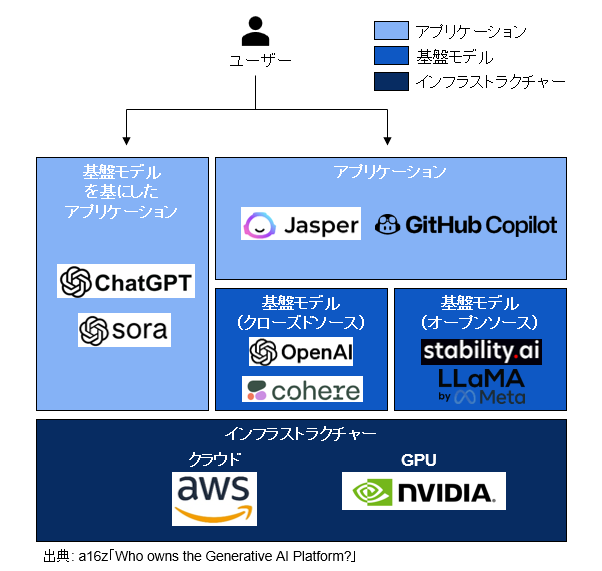

例えば企業内にある独自データの活用やモデルの微調整など(ex RAG、Fine-tuning)、個社ごとにカスタマイズして活用する必要が出てきます。そのため特に金融業界など特殊なユースケースが存在する業界ではバーティカル基盤モデルの参入余地がありそうです。

③インフラストラクチャー

概要:AIモデルの学習や推論に必要な計算リソースを提供する基盤のこと。この層には、クラウドサービスプロバイダー(ex Amazon)や、AI向けGPUを提供するハードウェアメーカー(ex NVIDIA)が含まれます。

AI特需の恩恵を受けるインフラ事業者

アプリケーションレイヤーや基盤モデルレイヤーのスタートアップが競争を繰り広げる中で、最もAI特需の恩恵を享受しているのはインフラ事業者です。AIモデルの学習や推論には、膨大な計算資源が必要であり、それを提供するインフラ事業者への需要が急増しています。

実際、AI向けGPUを供給するNVIDIAは、直近の決算(2024年10月)で、売上高・利益が倍増するなどAI企業の設備投資の恩恵を受けています。AI市場の拡大に伴い、インフラ事業者は今後も重要な役割を担い続けると予想されます。

インフラストラクチャーレイヤーでの勝ち筋

Amazonなどのクラウド事業者やNVIDIAなどのGPUメーカーなど、ビッグテックが競合となるのでスタートアップの入り込む余地はほとんど考えられない領域ではありますが、省電力データセンターなどニッチな領域での参入余地があるかもしれません。

図2: レイヤー別企業例

Cohere概要

Cohereは、2019年にカナダのトロントで設立された法人向けの大規模言語モデルと生成AIサービスを提供する会社です。大規模言語モデルを開発するスタートアップの中では、GPTモデルを開発するOpenAI、Claudeモデルを開発するAnthropicと並び称される企業であり、先ほどの生成AI市場の3つの分類のうち、②基盤モデルと①基盤モデルを基にしたアプリケーションを提供するスタートアップです。

Aidan Gomez CEOはトロント大学在学中にGoogle Brainにインターンとして勤務し、2017年に投稿された機械学習における著名な論文である”Attention Is All You Need”論文の共著者として、OpenAIの開発するGPTモデルの原型にもなったTransformerアーキテクチャを提案しています。

2024年までに合計4回の資金調達を行っており、合計調達金額は$942.9M、評価額は$5.5Bのユニコーン企業です。主要投資家には、Index Ventures、Tiger Global Managementがいます。

図3: Cohere概要

サービス内容と技術優位性

CohereはLLM(大規模言語モデル)プロバイダーの中でもエンタープライズに特化したLLMを開発しています。2024年4月に最新モデルであるCommand R+を発表しています。

特徴は以下の3つです。

図4: RAG概要

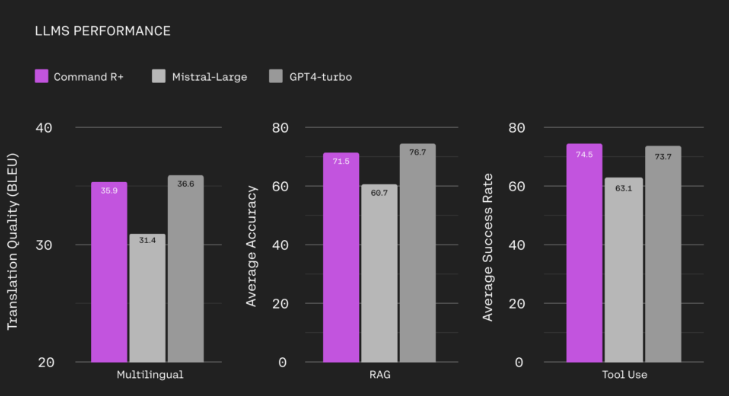

下図のように、Cohere が提供するモデルのCommand R+は、Mistral AIが提供するモデルのMistral-Large、OpenAIが提供するモデルのGPT4-turboと比較しても、①翻訳性能、②RAGの精度の高さ、③使いやすいユーザビリティ、の3つの技術優位性を持ちます。

図5 : Command R+の性能(※Cohere社HP)

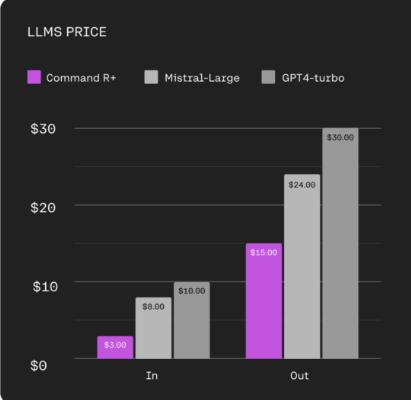

以上のような特徴を持つLLMをAPIベースで提供しており、API使用コストは上記2社と比較しても大幅に低いです。

図6: Command R+の価格

LLMに加えて、RAGを用いて社内文書を読み込むことで、精度高く、社内外の資料検索やカスタマーサポートに活用することができます。

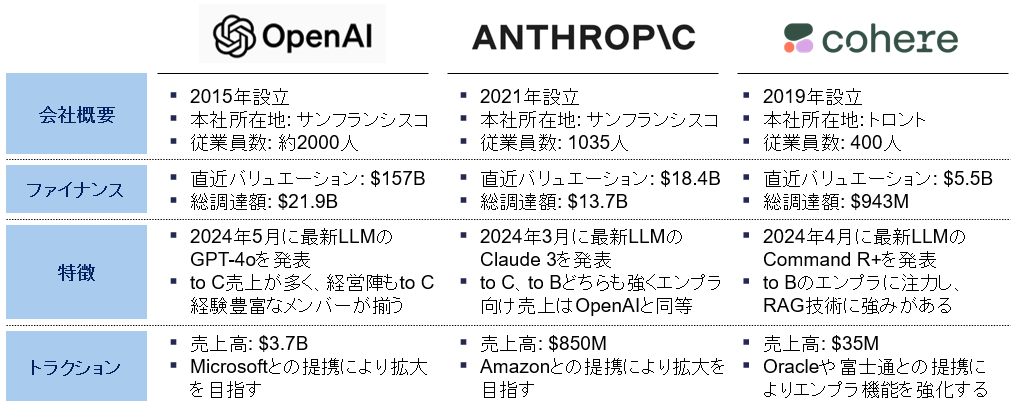

競合

Cohereの競合であるOpenAIとAnthropicをファイナンス、特徴、トラクションの観点から比較しました。組織規模の面では劣るものの他2社と比較してto Bのエンプラに特化する戦略を取ることで、一定のポジションを獲得しています。

汎用的な基盤モデル(ex OpenAI GPT4o)だと個社ごとの具体的なユースケースに当てはめづらいという課題があります。そこで、CohereはRAG技術を強化し、個社ごとにカスタマイズするアプローチをとることで、OpenAIやAnthropicなどの汎用的な基盤モデルと差別化しています。

図7: 競合比較

トラクション

2024年3月末の時点でCohereは数百社の顧客基盤を持ち、年間収益は$35Mで、2023年末の約$13Mから増加しています。

また、Oracleや富士通と提携し、CohereのLLM技術を用いたアプリケーションを開発し、エンプラ機能を強化しています。

おわりに

今回は生成AI特集の第一弾として、エンタープライズに特化したLLMを開発するCohereを紹介しました。世界では基盤モデルを開発するAIスタートアップが盛り上がっておりその中でもCohereはエンタープライズに特化し存在感を放っています。インフラストラクチャーは既にビッグテックが大量の資金を投下している領域でありスタートアップの参入は難しいです。基盤モデルに関してもCohereのように他社と異なるポジショニングを取ることで優位性を構築できる可能性がありますが、基本的には資本力・高度な技術力が必要であり、参入は容易ではありません。一方で日本のスタートアップとしては、AIモデル自体で差別化をせずとも、データ・オペレーションを差別化することで強固な参入障壁を築けるケースが多々あり、このような戦い方でメガベンチャーが生まれることが期待されます。特にVertical、エンタープライズ特化等の戦い方は非常に相性の良い戦略で、既にメガベンチャーが生まれつつある領域だと考えています。

次回以降も生成AIのスタートアップの事例を取り上げていきたいと思いますので乞うご期待ください。

参考資料

- 「Who Owns the Generative AI Platform?」a16z

- 「生成AIとSaaSの対比」 生成AIに関するレポート DNX Ventures